Nous savions déjà que le World Wide Web était un fabuleux outil de communication, d’échange et de partage d’information. A ce titre il constitue déjà un extraordinaire catalyseur de l’intelligence humaine (… qui présente aussi [inévitablement] sa face obscure avec la cybercriminalité).

Nous savions déjà que le World Wide Web était un fabuleux outil de communication, d’échange et de partage d’information. A ce titre il constitue déjà un extraordinaire catalyseur de l’intelligence humaine (… qui présente aussi [inévitablement] sa face obscure avec la cybercriminalité).

Ces trois fonctions d’Internet ont démultiplié le phénomène de la cross fertilization.

Le meilleur est à venir. Avec ce que l’on appelle les big data / open data, en phase d’explosion progressive dans leur utilisation. En effet, le Web offre aux chercheurs une vision virtuelle (entendez numérique) du monde, dont le champ des manipulations est bien plus grand que ce que permet le monde réel.

Je m’intéresserai plus particulièrement à l’aspect scientifique du phénomène.

Auparavant les découvertes scientifiques étaient le fruit conjugué de l’observation et de l’intuition.

Les big data / open data et les techniques de data mining sont occupées à bouleverser la donne. En collectant les masses d’information disponibles sur le Web et en cherchant les corrélations grâce aux outils de data mining, il va devenir possible de découvrir des lois nouvelles. Dit autrement le sujet de l’observation est en quelque sorte virtualisé, et des calculs de corrélation se substituent au cerveau humain dans la démarche d’intuition. Jusqu’à un certain point bien entendu, mais qui n’est finalement fonction que de la masse de données disponibles, de la puissance des machines et de l’efficacité des algorithmes utilisés.

Dès lors qu’ils veulent bien les mettre à disposition sur le Web, les résultats de l’observation et/ou de l’expérimentation des uns peuvent conduire des “chercheurs virtuels” à des découvertes inattendues, en faisant “simplement” travailler des ordinateurs.

Quelles accélérations et quelles économies potentielles dans les activités de recherches, fondamentales ou appliquées !

On pourrait objecter que la sélection des données demeure la principale difficulté : ne pouvant toutes les prendre en compte il faut savoir comment les choisir et donc avoir une idée de ce que l’on cherche.

Cette limitation ne doit pas devenir l’obstacle incontournable au plus gros avantage de la “recherche virtuelle” : sans coûts insupportables, pouvoir chercher tous azimuts, sans préjugés fixant les axes d’investigation. Les plus belles découvertes sont quelquefois le fruit du hasard.

La condition : offrir la puissance de calcul nécessaire. C’est possible grâce au calcul distribué et cela dépend aussi de chacun de nous : chaque propriétaire d’un ordinateur personnel peut décider d’offrir aux chercheurs une part de sa puissance de calcul, comme cela a déjà été fait lors du programme SETI@home de l’université Berkeley de Californie. Autre exemple, le projet FightAIDS@home, dans le cadre de la recherche de traitements contre le SIDA.

Et la place de l’expérimentation me direz-vous? Elle subsiste, bien entendu. Parce que les lois découvertes doivent évidemment être vérifiées. C’est le premier fondement d’une démarche scientifique. Et parce que les biais peuvent être nombreux dans l’accès aux données, qu’il faut donc hésiter à considérer trop vite comme “totales” (un objectif de toute manière inatteignable).

L’intérêt de la “recherche virtuelle” servira tant les sciences exactes que non exactes. L’importance de l’observation et de l’enquête étant plus grande dans les sciences non exactes, il semble évident que ces dernières y trouveront largement leur compte. Elles pourraient aussi y gagner un moyen de pallier à leur “achiffrisme” congénital.

La “recherche virtuelle”, rêve ou réalité? Deux exemple éloquents, parmi bien d’autres :

- Le projet du laboratoire de l’Université de Saint Andrews en Ecosse, visant à éclairer les liens de cause à effet entre les susbstances chimiques de certains médicaments et les effets secondaires associés (en exploitant la base de données américaine PubChem).

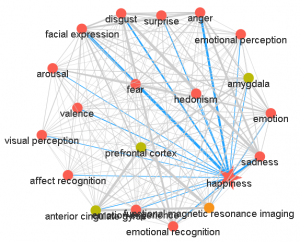

- Le projet brainSCANr (http://www.brainscanr.com – http://www.acceleratingfuture.com) de l’université Berkeley de Californie, pour trouver des pistes de guérison inédites dans le domaine des neurosciences.

Les big data / open data sur le Web peuvent aussi être utilisées à des fins plus directement concrètes, par exemple rechercher les meilleurs endroits pour implanter des éoliennes, en s’appuyant sur toutes les données météorologiques disponibles

Autre exemple encore : la recherche de gisements de gaz de schiste, en s’appuyant cette fois sur les données géologiques.

Enfin, dans le secteur public, l’exploitation des données disponibles dans les bases de données publiques ( Sécurité Sociale, Ministère des Finances, …) devrait permettre de renforcer l’efficacité des efforts de lutte contre les fraudes sociales et fiscales.

Un lien intéressant sur le sujet open data : http://opendatacommunities.org/data

_________

http://fr.wikipedia.org/wiki/Big_data

http://fr.wikipedia.org/wiki/Open_data

This Web page was created with PageBreeze Free HTML Editor

Leave a Reply