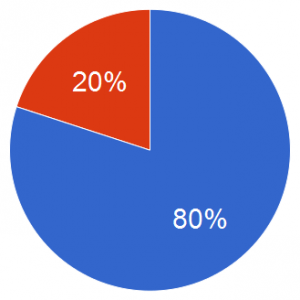

Een artikel in DeMorgen kopt: “Slimme software herleidt belastingcontroleurs ‘tot aapjes'”, en daaronder: “Digitale selectie zorgt voor ongelijke behandeling belastingplichtigen”. We begrijpen uit het artikel dat Financiën zich voor haar controles nu voor 80% baseert op risicoprofielen die door datamining naar voren worden geschoven, en dat dit tot grote frustratie leidt bij inspecteurs en controleurs. Een bekend probleem, waar een en ander over te vertellen valt. Een poging.

Aan de ene kant laten computerprogramma’s, meer bepaald datamining-algoritmes, toe om te leren uit vaststellingen gemaakt in het verleden, en kunnen zij op wetenschappelijk verantwoorde wijze aanleiding geven tot proactieve risicobepaling. De gebruikers dienen wel te beseffen dat het gaat om risico’s, en geen bewijzen. Controle ten gronde, of zelfs ter plaatse, is nodig. Maar datamining kan dus duidelijk bijdragen tot het efficiënter en doelgerichter werken van de overheid.

Aan de ene kant laten computerprogramma’s, meer bepaald datamining-algoritmes, toe om te leren uit vaststellingen gemaakt in het verleden, en kunnen zij op wetenschappelijk verantwoorde wijze aanleiding geven tot proactieve risicobepaling. De gebruikers dienen wel te beseffen dat het gaat om risico’s, en geen bewijzen. Controle ten gronde, of zelfs ter plaatse, is nodig. Maar datamining kan dus duidelijk bijdragen tot het efficiënter en doelgerichter werken van de overheid.

Bovendien kan automatisatie inderdaad willekeur en voorkeursbehandeling tegengaan, als daar sprake van zou zijn. Zo stelt ook de fiscus, volgens het artikel: “Sinds enkele jaren gebruikt de fiscus een computersysteem om te bepalen wie een controleur op bezoek krijgt. Op die manier wil de overheid willekeur en voorkeursbehandelingen vermijden.”

De tegenstanders, vaak inspecteurs en controleurs zèlf (maar lang niet allemaal), kunnen argumenteren dat de digitale selectie op basis van risicoprofielen net voor een ongelijke behandeling zorgt. Moeten we daar dan uit besluiten dat gelijke behandeling alleen kan mits controledoelen volledig random geselecteerd worden?

Een moderne overheid, die met minder middelen meer resultaat wil, zal niet iedereen kunnen controleren. Het is ook niet haalbaar, dat iedereen om de zoveel jaar gecontroleerd zou worden. Met het huidig effectief, zouden er immers teveel jaren tussen liggen. Maar controles ten gronde zijn nodig, omdat op basis van aangiftes en andere beschikbare digitale gegevens alleen, de juistheid en waarheid van aangegeven data niet kan bepaald worden (cfr. BOYDENS I., “Strategic Issues Relating to Data Quality for E-government: Learning from an Approach Adopted in Belgium”. In ASSAR S., BOUGHZALA I. et BOYDENS I., éds., “Practical Studies in E-Government : Best Practices from Around the World”, New York, Springer, 2011, p. 116 e.v.).

Gegeven dat selectie dus nodig is – is ieder selectieprincipe, dat niet volledig random (en dus blind) is, dan ongelijk en oneerlijk?

Ongelijk misschien wel, maar is dat oneerlijk?

Belastingplichtigen (individuen èn organisaties) gedragen zich niet gelijk – misschien is een daarop gerichte, wetenschappelijk verantwoorde (ongelijke, zo u wil) selectie dan wel eerlijk? Zolang de behandeling en afhandeling van de gecontroleerde op gelijke (en eerbare) wijze gebeurt, kan men toch stellen dat de overheid naar de geest een gelijke behandeling nastreeft – laat staan naar de letter.

In mijn ervaring als dataminer blijken de beste predictieve modellen steeds diegene die zich uitdrukken (dankzij bloed, zweet en tranen in doorgedreven business-analyse) in termen van gedrag (van een systeem, en waarom ook niet van een individu of organisatie). En dus niet alleen in termen van statische variabelen. Dit is een aspect dat ik als best practice wel zou willen meegeven aan iedereen die te maken heeft met selectie, en hopelijk gelijke en eerlijke behandeling nastreeft.

Tegelijk moet bij dit alles een dubbele caveat geformuleerd worden.

Ten eerste moet men ervoor zorgen dat de, overigens onbetwistbaar noodzakelijke, inspecteurs en controleurs niet tot “aapjes” of papegaaien gereduceerd worden, en dat hun terreinervaring blijvend gevaloriseerd wordt. Zowel bij de ontwikkeling van datamining-gedreven systemen als de evolutie ervan, en de ontwikkeling van feedback-systemen die vaststellingen en resultaten registeren. Telkens opnieuw blijkt dit cruciaal voor succes.

Ten tweede, en dit sluit naadloos aan bij de terreinervaring van zulke inspecteurs en controleurs (en waarom niet, ook die van andere betrokken partijen), moet men steeds, naast datamining- en andere geautomatiseerde risicogedreven criteria, tegelijk andere selecties toelaten. Enerzijds random, om minstens de mogelijkheid te verzekeren dat iedereen aan de beurt kan komen – ook degene die onder de reeds geïnstalleerde radars doorglippen. Anderzijds kan de voeling met het terrein van onschatbare waarde zijn om snel genoeg, doelgerichte controleacties uit te voeren. Mits duidelijke afspraken en geregistreerde motivatie voor zulke keuzes, moet dit kunnen.

Verder wil ik nog inpikken op de 80/20 (%) verdeling voor de controles. Zoals gezegd in het artikel worden op dit moment 80% van de controles automatisch geselecteerd op basis van datamining. Of dit een goede verdeling is, hangt af van wat men zou kunnen noemen de dekkingsgraad van de geïmplementeerde predictieve modellen en risicoprofielen t.o.v. de zich in de werkelijkheid voordoende fenomenen en scenario’s. De datamining-modellen worden gevoed met voorbeelden van een welbepaald type probleem of doel. Indien uit de vaststellingen in het kader van de 80% op datamining geïnspireerde controles blijkt dat men steeds dezelfde, beperkte set van resultaten boekt, terwijl men vroeger (of nu, in het kader van de 20% anderszins geïnspireerde controles) meer verschillende – laat staan, belangrijkere – vaststellingen en rechtzettingen optekende, dan lijdt men er duidelijk aan teveel in dezelfde vijver te vissen, en is de 80/20 regel hier aan herziening toe. Of het dan 50/50 moet zijn? Men doet er goed aan te luisteren naar het terrein, het te proberen, en vervolgens rigoureus de resultaten te registreren en te vergelijken. Meten is weten.

Verder wil ik nog inpikken op de 80/20 (%) verdeling voor de controles. Zoals gezegd in het artikel worden op dit moment 80% van de controles automatisch geselecteerd op basis van datamining. Of dit een goede verdeling is, hangt af van wat men zou kunnen noemen de dekkingsgraad van de geïmplementeerde predictieve modellen en risicoprofielen t.o.v. de zich in de werkelijkheid voordoende fenomenen en scenario’s. De datamining-modellen worden gevoed met voorbeelden van een welbepaald type probleem of doel. Indien uit de vaststellingen in het kader van de 80% op datamining geïnspireerde controles blijkt dat men steeds dezelfde, beperkte set van resultaten boekt, terwijl men vroeger (of nu, in het kader van de 20% anderszins geïnspireerde controles) meer verschillende – laat staan, belangrijkere – vaststellingen en rechtzettingen optekende, dan lijdt men er duidelijk aan teveel in dezelfde vijver te vissen, en is de 80/20 regel hier aan herziening toe. Of het dan 50/50 moet zijn? Men doet er goed aan te luisteren naar het terrein, het te proberen, en vervolgens rigoureus de resultaten te registreren en te vergelijken. Meten is weten.

Opletten trouwens: de ene controle is de andere niet. Met inbegrip van de afhandeling van onderzoeken tot en met het resultaat, zijn er zwaardere dossiers en lichtere. Niets zegt dus dat de totale effort van inspecteurs en controleurs per dossier diezelfde 80/20-verdeling zal volgen. En voor de 20% anders gekozen controles, moet er ook voldoende tijd zijn om de selectie op een degelijke manier te doen.

Besluit

Het is mijn stelling dat analytisch gedreven werken, het aansturen van kernprocessen op basis van data en gekwantificeerde risico’s, niet fundamenteel verkeerd, ongelijk, of oneerlijk is. Meer nog, een moderne overheid moet zich in de huidige budgettaire omstandigheden verplicht zien om efficiënt en doelgericht te werken, en de hiertoe beschikbare, wetenschappelijk verantwoorde middelen in te zetten. Echter zonder blind te worden voor de beperkingen daarvan. Er is een gulden middenweg tussen automatisatie en voeling met het terrein.

Leave a Reply