Learning by doing. Feedback is cruciaal.

Nadat we vorig jaar in de infosessie “Streamlining Analytics” enkele praktische aspecten in detail konden belichten (in a nutshell: overwinnen van barrières bij de introductie van Analytics in de organisatie – architectuur, data quality, methodologie – cfr. slideshare, research note), is het hoog tijd om een andere belangrijke succesfactor voor Predictive Analytics onder de loep te nemen: feedback.

Nadat we vorig jaar in de infosessie “Streamlining Analytics” enkele praktische aspecten in detail konden belichten (in a nutshell: overwinnen van barrières bij de introductie van Analytics in de organisatie – architectuur, data quality, methodologie – cfr. slideshare, research note), is het hoog tijd om een andere belangrijke succesfactor voor Predictive Analytics onder de loep te nemen: feedback.

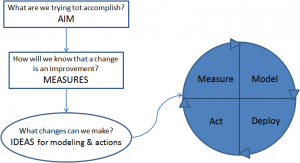

Een predictief model heeft slechts waarde als het ook ingezet wordt in processen. Dit wil zeggen dat de voorspelling die het model levert, geëxploiteerd wordt om actie te ondernemen: om in te grijpen in het productieproces of om beslissingen te nemen in een business-proces, met een welbepaald doel. Het is vervolgens van het allergrootste belang om de werkelijke uitkomst te registreren en te confronteren met de voorspelde. Die ‘werkelijke uitkomst’, voorzien van de juiste metadata, noemen we de feedback.

Waarom is deze feedback-registratie zo belangrijk? De ervaring die we in afgelopen en doorlopende projecten opdeden, leert ons dat nauwkeurige feedback-registratie een cruciaal, zoniet het belangrijkste, element vormt voor de realisatie van meerwaarde op de volgende vlakken:

Waarom is deze feedback-registratie zo belangrijk? De ervaring die we in afgelopen en doorlopende projecten opdeden, leert ons dat nauwkeurige feedback-registratie een cruciaal, zoniet het belangrijkste, element vormt voor de realisatie van meerwaarde op de volgende vlakken:

- opvangen van het gebrek aan trainingsdata – de verwachte nauwkeurigheid opdrijven;

- kwantificeren van de werkelijke nauwkeurigheid – rapporteren;

- opvangen van evolutie – nauwkeurig blijven;

- innovatie en procesinnovatie mogelijk maken.

Opvangen van het gebrek aan trainingsdata – de verwachte nauwkeurigheid opdrijven

De karakteristieken van het trainingsproces doen ons dit onmiddellijk inzien. Even recapituleren om wat termen in te voeren en het predictive-analyticsproces te verduidelijken:

- Predictive analytics bedient zich in een trainingsfase van algoritmen en invoerdata om een formule (een model, een patroon) op te stellen. Deze formule drukt zich uit in termen van variabelen uit de invoerdata (de zogenaamde ‘onafhankelijke’ variabelen), en berekent een verwachte waarde voor een doelvariabele (de ‘afhankelijke’ variabele). De doelvariabele drukt uit waar het voor de business om te doen is. Bv. de onafhankelijke variabelen zijn afgeleid van reeksen biometrische waarden, gemeten bij een gemonitorde patiënt; de afhankelijke variabele is het optreden van nierfalen binnen een zekere tijd.

- Predictive Analytics moet dus teruggrijpen naar historische data, waarbij voor een voldoende groot gedeelte de doelvariabele, de uitkomst van wat men wenst te voorspellen, bekend is (‘gelabelde’ data).

- De verwachte nauwkeurigheid van een predictief model kan dan worden berekend in functie van hoeveel keer de berekende verwachte waarde van de doelvariabele correct of incorrect blijkt.

- Als de verwachte nauwkeurigheid voldoende groot is, en het model is voldoende stabiel, dan kan de formule van het model ‘predictief’ ingezet worden, om de verwachte uitkomst te berekenen voor nieuwe invoerdata waarvan de doelvariabele nog niet bekend is (‘ongelabelde’ data).

Het is een statistische wetmatigheid, en in de praktijk ondervinden we het ook zo, dat de (verwachte) nauwkeurigheid van een predictief model verhoogt naarmate er meer gelabelde trainingsdata voorhanden zijn. Een tweede wetmatigheid zegt dat hoe meer (onafhankelijke) invoervariabelen er zijn, dus hoe complexer of rijker het model, hoe meer trainingsdata er minimaal nodig zijn voor een stabiel, robuust model. Een derde stelt dat de ongelijke verdeling van de doelvariabele een invloed heeft op de nauwkeurigheid waarmee het model in staat is de verschillende voorkomende waarden van de doelvariabele te voorspellen.

In de praktijk is het echter meestal zo dat er te weinig gelabelde data voorhanden zijn, of toch minder dan wenselijk. Dit omdat het duur of moeilijk is om ze te bemachtigen (denk bv. aan medische experimenten). Bij ongelijke verdeling van de doelvariable zal men typisch geconfronteerd zijn met het feit dat net de interessantste waarde het minst voorkomt.

Besluit:

Wie bij het inzetten van een predictief model in een proces, ook zorgt voor een nauwgezette registratie van de werkelijke uitkomst, beschikt na verloop van tijd over méér gelabelde data, en zal dus in staat zijn betere predictieve modellen te bouwen: nauwkeuriger, robuuster, gerichter.

Kwantificeren van de werkelijke nauwkeurigheid – rapporteren

The proof is in the pudding. Het is weinig interessant te beschikken over een model dat een hoge verwachte nauwkeurigheid kent, als het in de praktijk niet werkt. Het is evident dat slechts de registratie van de werkelijke uitkomst ons in staat stelt te rapporteren over de werkelijke nauwkeurigheid, de ‘performantie’ van het model.

Waar de werkelijke nauwkeurigheid sterk afwijkt van de verwachte, valt ongetwijfeld veel te leren uit het bestuderen van individuele cases waar de predictie verschilt van de geregistreerde uitkomst = feedback. Dit verhoogt het inzicht in de eigen business-context.

Verder hoeft het geen betoog dat de feedbackregistratie best gestructureerd, elektronisch, gebeurt. Dit maakt een regelmatige, automatische rapportering mogelijk, en maakt het ook mogelijk de performantie van een predictief model op te volgen in de tijd. Wat ons naadloos brengt tot het volgende punt.

Opvangen van evolutie – nauwkeurig blijven

De werkelijkheid evolueert. De context van elk proces zal in de tijd dus steeds veranderen. Men mag dus verwachten dat ook een predictief model mettertijd gaat slijten. Dankzij feedback-registratie zijn we nu niet alleen in staat deze daling in perfomantie waar te nemen, maar kunnen we er nu ook iets aan doen! Het volstaat immers de ‘oudste’ gelabelde data te laten vallen en te vervangen door ‘nieuwe’, waarvoor de uitkomst dus werd geregistreerd.

In het geval de feedback elektronisch is geregistreerd, is het ook mogelijk dit in een continu proces te gieten, waarbij een glijdend tijdsvenster wordt gebruikt bij automatisch opstellen van trainingsdata. Aldus berekent men op regelmatige wijze een nieuw predictief model, en blijft men constant “leren” in de evoluerende context.

Innovatie en procesinnovatie mogelijk maken

Met predictive analytics wil men vaak een nieuw probleem aanpakken, een nieuwe opportuniteit aanboren, een risico of fenomeen dat men voorheen niet expliciet, of expliciet genoeg, registreerde. Bv. voor fraudebestrijding: misschien deed men dit voorheen niet, of niet expliciet op een data-gedreven manier. Of bv. in de context van de medische wetenschap: het kan zijn dat men voorheen slechts een algemeen nierfalen benoemde, herkende, en registreerde, daar waar men nu voor een specifiek of gevaarlijk subtype een gerichtere, nauwkeurigere diagnose- of zorgondersteuning wenst uit te bouwen.

Met predictive analytics wil men vaak een nieuw probleem aanpakken, een nieuwe opportuniteit aanboren, een risico of fenomeen dat men voorheen niet expliciet, of expliciet genoeg, registreerde. Bv. voor fraudebestrijding: misschien deed men dit voorheen niet, of niet expliciet op een data-gedreven manier. Of bv. in de context van de medische wetenschap: het kan zijn dat men voorheen slechts een algemeen nierfalen benoemde, herkende, en registreerde, daar waar men nu voor een specifiek of gevaarlijk subtype een gerichtere, nauwkeurigere diagnose- of zorgondersteuning wenst uit te bouwen.

In die gevallen start men dan zonder gelabelde data, of in het beste geval met ‘onnauwkeurig getypeerde’ data. Bv. voor fraudebestrijding heeft men boetes geregistreerd, maar men kan fraude niet onderscheiden van vergissingen e.a. Bv. nierfalen: aanvankelijk heeft men slechts trainingsdata voor het algemeen type.

In elk geval dient men een nieuw afhandelproces te definiëren, waarbij men voor nieuwe dingen aandacht heeft, en waarbij men nauwkeurig, met de juiste metadata, de uitkomst registreert. Deze feedback kan dan op termijn wel geëxploiteerd worden in een echt predictief model.

Conclusie

We willen hiermee vooral de goede raad meegeven om van bij het begin het ganse proces te beschouwen, en in het afhandelproces (na actie in functie van predictie) te voorzien om goed getypeerde feedback te registreren. Zodanig dat die feedback, liefst volledig geautomatiseerd, geëxploiteerd kan worden voor het opvolgen van modelperformantie en voor constante bijsturing van predictieve modellen. Het adagium is: “Learning by Doing, and Continue to Learn”.

Hoe slimmer de feedbackregistratie is opgezet, hoe meer mogelijkheden de organisatie zal hebben om haar inzicht te vergroten en predictieve modellen te richten op voorheen onontgonnen terreinen.

Leave a Reply