Dit artikel is ook te lezen in het Nederlands.

Cet article a été traduit du néerlandais. Les liens peuvent pointer vers des sources en néerlandais.

Le 30 novembre 2022, ChatGPT a été révélé au monde entier. Le chatbot polyvalent, qui peut traiter de presque tous les sujets, a immédiatement conquis un large public. Les générateurs d’images, tels que DALL-E et Stable Diffusion, sont venus s’ajouter à cela et, aujourd’hui, la situation est claire : L’IA générative a de beaux jours devant elle. Nous avons nous-mêmes commencé à l’utiliser immédiatement, et nous avons écrit un article sur nos premières découvertes 10 jours après le lancement.

1 an plus tard, l’impact de ChatGPT peut être qualifié de transformateur. L’écosystème autour de l’IA générative est en plein essor. Ce qui relevait du domaine des rêveries irréalistes il y a 3 ans est soudain devenu réalisable et est en production aujourd’hui. D’innombrables start-ups voient le jour : le compteur du site web There’s an AI for that a depuis dépassé les 10 000, le mois de mars 2023 comptant à lui seul 1209 nouvelles entreprises d’IA. À titre de comparaison, pour l’ensemble de l’année 2021, il n’y a que 288 start-ups dans la même base de données.

L’impact et la célérité avec lesquels tout évolue suscitent également de la nervosité. L’enseignement, par exemple, doit s’adapter dans la précipitation à une nouvelle réalité. L’étudiant moyen a désormais facilement accès à une technologie qui lui permet de rédiger une dissertation entière en quelques secondes – et lorsque South Park y consacre un épisode, on sait que le phénomène prospère. Plus proche de nous, de nombreuses universités ont publié des lignes directrices ou des conseils sur son utilisation (par ex. Louvain, Gand, Anvers). Celles-ci sont bien pensées et pourraient bien inspirer des lignes directrices similaires dans les entreprises et les gouvernements.

L’on observe également de nombreuses expérimentations dans des contextes professionnels. “Aucune idée, mais demande à ChatGPT” est devenu une déclaration typique lorsqu’il y a un besoin de nouveaux inputs. Un sondage réalisé par Nature a fait ressortir qu’un grand nombre de scientifiques avaient déjà exploré la technologie dans un cadre professionnel. Dans le monde universitaire, l’on se demande si le fait de soumettre d’épais dossiers de subvention a un sens, si la rédaction de ceux-ci est automatisable. Nul doute que des observations similaires émergent également dans d’autres secteurs.

Petite rétrospective

OpenAI mène toujours la danse, et son propre blog donne un bon aperçu des développements de l’année écoulée. Une timeline avec quelques moments clés :

- 17 janvier 2023 : Microsoft lance le service Azure OpenAI, rendant les technologies OpenAI disponibles sur Azure,

- 1 février 2023 : Le service d’abonnement ChatGPT Plus offre un accès prioritaire à ChatGPT (hautement sursollicité) pour 20 $/mois,

- 1 mars 2023 : ChatGPT devient disponible via API,

- 14 mars 2023 : Lancement de GPT-4 pour les utilisateurs de ChatGPT Plus,

- 23 mars 2023 : Lancement des premiers plugins,

- 13 juin 2023 : Une version mise à jour de ChatGPT peut configurer et exécuter des appels vers des fonctions externes,

- 20 juillet 2023 : Avec “custom instructions“, ChatGPT peut être configuré pour toujours prendre en compte certains éléments,

- 22 août 2023 : L’API Finetuning permet d’affiner l’output de ChatGPT,

- 28 août 2023 : Lancement de ChatGPT Enterprise,

- 25 septembre 2023 : Les utilisateurs peuvent utiliser la voix et les images dans les conversations,

- 19 octobre 2023 : ChatGPT peut générer des images avec DALL-E 3,

- 6 novembre 2023 : Introduction des GPT qui permettent aux amateurs de construire un ChatGPT personnalisé qui fouille des documents spécifiques, et des Assistants API destinée aux programmeurs pour réaliser une action similaire.

Ce dernier pas n’est pas reçu par tous avec enthousiasme : de nombreuses start-ups dans l’écosystème de l’IA générative viennent de construire le cœur de leur activité autour du concept de Retrieval-Augmented Generation (RAG), et OpenAI leur fait directement concurrence avec ses GPT personnalisés. (De mauvaises langues prétendent que cela aurait joué un rôle dans le conflit du CEO deux semaines plus tard, mais ces rumeurs n’ont pas encore été prouvées).

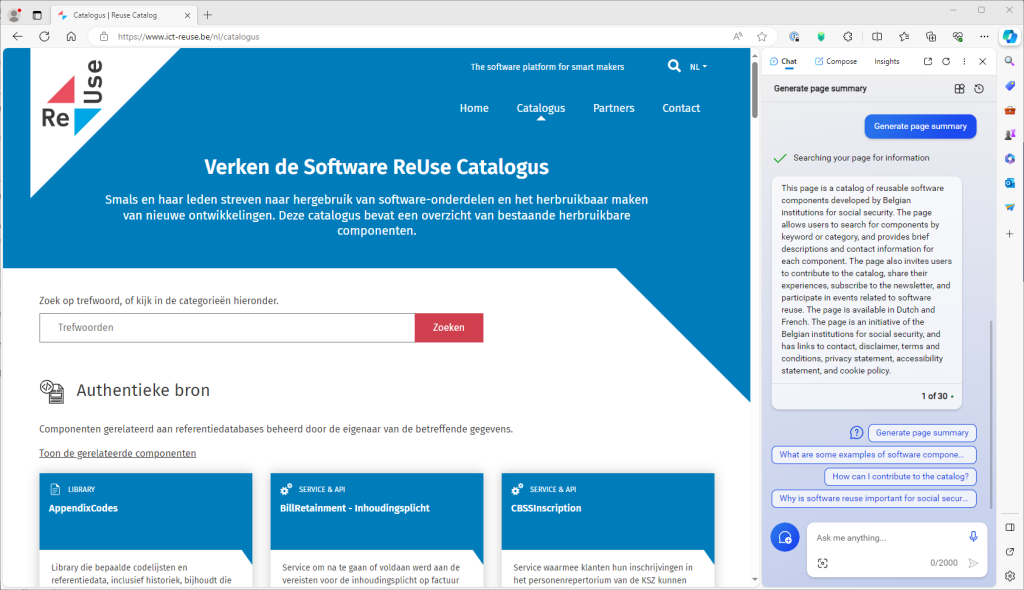

Retrieval-Augmented Generation (RAG), avec langchain comme bibliothèque la plus populaire pour les développeurs, est devenu au cours de l’année écoulée le moyen de faire en sorte que les Large Language Models s’accrochent à des informations spécifiques, internes ou récentes. L’idée découle du fait que, pendant ce temps, le prompt – c’est-à-dire la commande que l’on donne au modèle de langue – peut être si long qu’il y a de la place pour ajouter des pages entières d’informations supplémentaires. En enrichissant le prompt avec, par exemple, les résultats d’une recherche ou les dernières nouvelles, un chatbot peut encore formuler des réponses basées sur des informations récentes ou du contenu provenant de bases de données spécifiques, sans que le modèle de langue sous-jacent n’ait besoin d’être entraîné sur ces bases.

Microsoft s’est empressé de concrétiser cette idée. Avec Bing Chat, elle a lancé une nouvelle interface de recherche conversationnelle, qui utilise les résultats de Bing Search pour ses réponses. L’avantage est que cette interface peut afficher de manière transparente les citations de sources ou les références. Cependant, il convient de garder à l’esprit que cela ne garantit pas l’exactitude des réponses : les résultats de la recherche peuvent toujours ne pas être pertinents, et les résumés incorrects ou incomplets. Entre-temps, le produit fut un succès, et Microsoft a décidé de mettre le paquet : entre-temps, Bing Chat a été rebaptisé Microsoft CoPilot, a été intégré au navigateur Edge, et est également disponible dans Windows 11 et Microsoft 365 (anciennement Office). Pour pouvoir exploiter cette fonctionnalité, il faut donner l’autorisation dans l’application de partager des documents ouverts ou des contenus de pages web avec le service CoPilot.

Microsoft fait également figure de précurseur en matière d’images : Le Bing Image Creator offre un accès gratuit au générateur DALL-E 3 (pour l’instant), et ses résultats sont intégrés de manière transparente dans le nouveau Microsoft Designer.

Google a eu moins de succès avec son équivalent Bard. Le lancement a mal tourné lorsque Bard a répondu par un fait erroné (une hallucination), ce qui a fait chuter le cours de l’action de Google. Par rapport à OpenAI et Microsoft, Google semble moins préoccupé par l’intégration et l’expérience utilisateur, et se concentre plutôt sur le fond théorique et l’approfondissement des possibilités technologiques.

Meta, bien sûr, ne veut pas être en reste et joue la carte du logiciel quasi open-source avec ses propres modèles de langue Llama, en mettant l’accent sur le terme “quasi”. La société semble se concentrer principalement sur les développeurs individuels, pour lesquels Meta souhaite faciliter la réutilisation ou le réentraînement de leurs modèles de langue, comme l’a fait Stanford avec sa variante Alpaca, entre autres. La société vise également le déploiement sur du matériel standard, grâce à la bibliothèque llama.cpp, qui permet de quantifier un modèle : arrondir intelligemment les paramètres d’un modèle entraîné pour réduire l’empreinte mémoire, au prix d’une perte de précision faible mais acceptable. Une quantification de 32 bits à 8 bits fait qu’un modèle de 13 milliards de paramètres nécessite non pas 52 Go mais seulement 13 Go de mémoire vive. Il s’intègre donc parfaitement dans la mémoire des cartes graphiques actuelles dotées de 16 ou 24 Go de vRAM. Des outils intuitifs permettant d’héberger des modèles quantifiés sur votre propre ordinateur sont GPT4All , MLC, ollama ou LMStudio.

Plusieurs entreprises plus petites sont également dans la course, développant leurs propres modèles de langue qui pourraient servir de backend pour des services de type ChatGPT ou des applications RAG. Il convient de mentionner Anthropic, créée par d’anciens employés d’OpenAI, qui met particulièrement l’accent sur la transparence et la sécurité avec ses modèles Claude. De son côté, l’européenne Mistral a démarré sur les chapeaux de roues. Avec d’anciens employés de Meta à sa tête, elle exploite un modèle véritablement open-source et est donc principalement en concurrence avec Meta. Pour la zone linguistique néerlandaise, des projets sont en cours pour développer, par l’intermédiaire de l’organisation de recherche TNO, un GPT-NL indépendant qui devrait également constituer une alternative aux grands acteurs américains, en mettant l’accent sur le respect des lois européennes.

Petite prospective

Bon nombre d’entreprises doivent encore s’atteler à l’adaptation de leurs propres modèles d’entreprise à l’essor de l’IA. Nous n’en sommes toutefois qu’aux premiers stades d’une période de forte croissance pour l’IA, et il est difficile de prévoir ce que les prochaines années nous réservent. Rester à l’affût des évolutions est une première étape. The Batch de DeepLearning.AI est une newsletter excellente qui suit l’évolution de la situation et qui fournit chaque semaine un résumé concis des événements clés de l’industrie. Ceux qui cherchent à élargir et à approfondir leurs connaissances trouveront également une solide offre de cours sur le même site web, comme celui-ci : Generative AI for Everyone. Microsoft propose un cours Generative AI for Beginners (IA générative pour les débutants) destiné aux développeurs. Le site finlandais Elements Of AI propose l’un des cours gratuits les plus accessibles au grand public, et il en existe bien d’autres.

Aujourd’hui déjà, les chefs d’entreprise et les dirigeants sont confrontés à tous ces nouveaux développements dans les entreprises ou dans l’administration, et veulent formuler une réponse – ou au moins élaborer un code de conduite. Le moniteur de gestion du Knowledge Centre Data and Society rassemble des exemples nationaux et internationaux qui peuvent servir d’inspiration à ceux qui ne veulent pas réinventer l’eau chaude. Le AI Standards Hub du Royaume-Uni rassemble des publications pertinentes sur les normes industrielles liées à l’IA. À un niveau international plus abstrait, l’OCDE, entre autres, exerce un monitoring actif. L’évolution rapide du terrain ne facilite certainement pas le travail législatif. Au niveau européen, le IA Act annoncé est reporté. Cela n’a pas empêché Stanford d’évaluer déjà les principaux acteurs existants sur la base du projet de texte qui nous est soumis.

En attendant, rien n’empêche une entreprise ou un gouvernement de se lancer et d’expérimenter la technologie. Toutefois, il est crucial de rester prudent et de ne pas pas perdre le sens commun. ChatGPT n’est pas une solution miracle. Aucun mécanisme de sécurité ne peut garantir qu’un modèle de langue n’aura pas d’hallucinations ou ne présentera pas des textes complètement inventés comme des faits. Bien que les datasets d’entraînement de nombreux modèles de langue soient secrets, nous savons qu’ils sont si volumineux qu’il est impossible d’y effectuer une sélection et un filtrage précis. Les LLM sont aujourd’hui des boîtes noires ; il est impossible de retracer l’origine d’un choix de mots particulier dans une réponse. Il est donc impossible, en toute logique, de créer des applications critiques aveuglément sur la base de ces systèmes. De toute évidence, ce serait une mauvaise idée de faire traiter des données médicales, sans aucune supervision, par un modèle de langue partiellement formé sur des textes piochés au hasard sur le net par des théoriciens du complot, des antivax, des influenceurs d’Instagram, des homéopathes et d’autres charlatans.

En parlant de charlatans, on voit régulièrement apparaître des prophètes de malheur qui, pour attirer l’attention, font des déclarations de plus en plus grotesques, allant jusqu’à prédire l’extinction de I’Humanité. (L’inverse existe aussi : ceux qui croient que l’utopie est proche). La disproportion de ces déclarations témoigne d’un manque de connaissances et d’un manque de contact avec la réalité. Après tout, malgré tous les progrès réalisés, nous sommes encore bien loin des robots capables de repasser vos vêtements. Des affirmations farfelues détournent la discussion des problèmes qui se posent aujourd’hui dans le monde réel : les abus tels que les “deepfakes“, l’élargissement de la fracture numérique, le manque de possibilités de contester les décisions automatiques, l’utilisation de données sans autorisation ni mention de la source, … autant de questions qui requièrent une attention soutenue et pour lesquelles l’Europe joue un rôle actif de pionnier. Ces éléments ne doivent pas être des facteurs bloquants, puisque même en gardant la tête sur les épaules, ce ne sont pas les opportunités qui manquent.

Dans un récent éditorial, Bill Gates a été acclamé pour sa vision de l’évolution dans un avenir proche. Selon cette vision, les chatbots évolueront en “agents“, c’est-à-dire qu’ils disposeront d’une autonomie (limitée) pour prendre des mesures, éventuellement supervisées. Là où les co-Pilots font encore partie d’une application, ceux-ci deviendront également plus génériques, avec l’intention que les futurs agents puissent fonctionner à travers les applications, comme les assistants personnels. En effet, il reste encore beaucoup de travail à accomplir pour y parvenir : des protocoles qui permettent aux applications de mieux communiquer entre elles, des moyens d’échanger des données en toute sécurité tout en préservant la vie privée, …

Enfin, la dépendance à l’égard de modèles énormes et non transparents (GPT-3, GPT-4) avec un service en cloud externe reste une pilule difficile à avaler lorsque des données internes ou sensibles sont susceptibles d’être traitées. Il est impossible de prévoir quelles données un utilisateur typique pourrait communiquer à un chatbot, et avec les plugins de type CoPilot, il est souvent difficile de retrouver les données que le plugin lit et transmet en arrière-plan. Toutefois, le RGPD impose des exigences strictes et concrètes. Tout le monde ne considère pas qu’une promesse ou même un accord contractuel stipulant que les données reçues ne seront pas stockées ou réutilisées soit suffisant pour avoir soudainement une confiance aveugle.

L’alternative logique consiste à déployer localement des modèles plus petits. Cependant, la qualité de leur output est par conséquent plus faible, ce qui est décevant si les attentes élevées créées par ChatGPT sont le point de référence. Les modèles plus petits ne disposent pas du multilinguisme fluide de ChatGPT et travaillent avec des prompts beaucoup plus compacts, ce qui complique l’élaboration d’applications RAG. Une recherche diligente et multidirectionnelle est en cours pour combler cette lacune. On voit des innovations permettant d’affiner (spécialiser) des modèles plus petits pour une tâche spécifique, de façon efficace et avec moins de données. Le concept de distillation – compression d’un modèle – semble également prometteur. Il semble également préférable de s’entraîner sur peu de données correctes mais de qualité, plutôt que sur un grand nombre de données désordonnées et potentiellement erronées. En outre, pour toute application, il reste à trouver les bons équilibres en termes de choix de modèle, l’ingénierie du prompt, le réglage fin et le RAG.

Le terrain de jeu est bel et bien ouvert, l’innovation ne manque pas, et nous pouvons certainement nous attendre à de nouvelles améliorations dans un avenir proche. Une année des plus intéressantes nous attend sans aucun doute !

______________________

Cette contribution a été soumise par Joachim Ganseman, consultant IT chez Smals Research. Elle a été rédigée en son nom propre et ne prend pas position au nom de Smals.

Leave a Reply